Qu’est-ce que les modèles o3 et o3-mini d’OpenAI ?

OpenAI vient de franchir une étape majeure avec ses nouveaux modèles d’intelligence artificielle, o3 et o3-mini. Conçus pour répondre aux enjeux les plus complexes en matière de raisonnement et de résolution de problèmes, ces modèles succèdent au o1 en apportant des performances impressionnantes. Ils ne se contentent pas de rivaliser avec leurs prédécesseurs : ils redéfinissent les standards de l’IA. Dans cet article, nous explorerons les tests qui mettent en lumière leurs capacités et leur place face à une concurrence féroce.

- Qu’est-ce que les modèles o3 et o3-mini d’OpenAI ?

- Trois points importants à retenir

- Pourquoi OpenAI a sauté o2 ?

- Une évaluation rigoureuse des performances du modèle OpenAI O3

- Qu'est-ce qu'OpenAI O3 mini ?

- La sécurité au cœur de la stratégie : l’alignement délibératif

- Dates de sortie et stratégie de déploiement

- Une place de choix face à la concurrence

- Les dernières avancées vers l'AGI

- Conclusion

- FAQ

Trois points importants à retenir

- Des performances révolutionnaires : Les modèles o3 et o3-mini surpassent leurs prédécesseurs, notamment sur des benchmarks comme SWE-Bench et ARC AGI, démontrant des capacités de raisonnement et de généralisation exceptionnelles.

- Une sécurité renforcée : Avec des approches innovantes comme l’alignement délibératif et la mise en place d’un Comité de sûreté, OpenAI montre un engagement clair en faveur du développement responsable de l’IA.

- Une avancée vers l’AGI : o3 marque une étape significative dans le cheminement vers l’intelligence artificielle générale, dépassant même les performances humaines sur certains tests critiques.

Pourquoi OpenAI a sauté o2 ?

Lors de l’annonce des modèles o3 et o3-mini, OpenAI a expliqué sa décision de ne pas lancer un modèle intermédiaire o2. Cette décision a été partiellement motivée par le souhait d’éviter toute confusion avec la marque O2 de Telefonica. Cependant, elle semble également refléter une stratégie plus profonde : signaler un bond technologique majeur. Sam Altman, PDG d’OpenAI, a lui-même plaisanté en disant que la nomenclature n’était pas leur point fort, mais le choix démontre clairement l’ambition d’o3.

Une évaluation rigoureuse des performances du modèle OpenAI O3

Pour juger de la portée des modèles o3 et o3-mini, plusieurs tests standardisés ont été réalisés. Ces évaluations ne mesurent pas seulement la puissance brute des modèles, mais aussi leur capacité à raisonner de manière délibérée et adaptative.

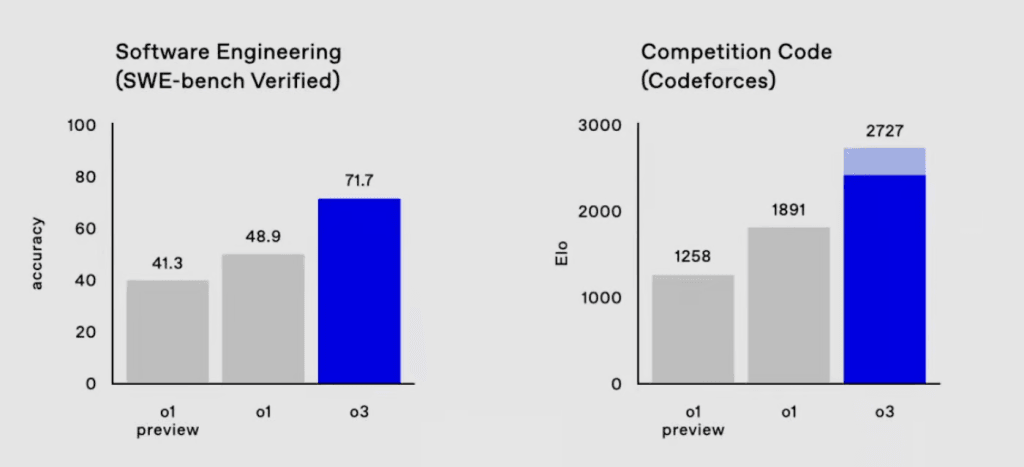

SWE-Bench Verified : le test de la programmation avancée

La programmation est un domaine où les modèles d’IA doivent exceller pour être utiles aux développeurs. Le benchmark SWE-Bench Verified a été spécialement conçu pour évaluer cette compétence. Sous la houlette d’experts du MIT et de Google Research, ce test mesure la capacité des modèles à résoudre des problèmes de codage complexes. Le modèle o3 s’illustre avec une progression impressionnante, atteignant une précision de 71,7 %, contre 48,9 % pour o1. Ces résultats témoignent de la capacité d’o3 à produire des solutions optimales dans des scénarios pratiques.

Codeforces : à l’épreuve de la compétition humaine

Sur Codeforces, plateforme bien connue des programmeurs compétitifs, les performances d’o3 impressionnent. Ce test simule des scénarios réels et exigeants. Avec un score ELO de 2727, o3 surpasse largement o1, qui culminait à 1891. Ces résultats illustrent une avancée significative, rendant le modèle plus apte à résoudre des défis de programmation complexes et concurrentiels.

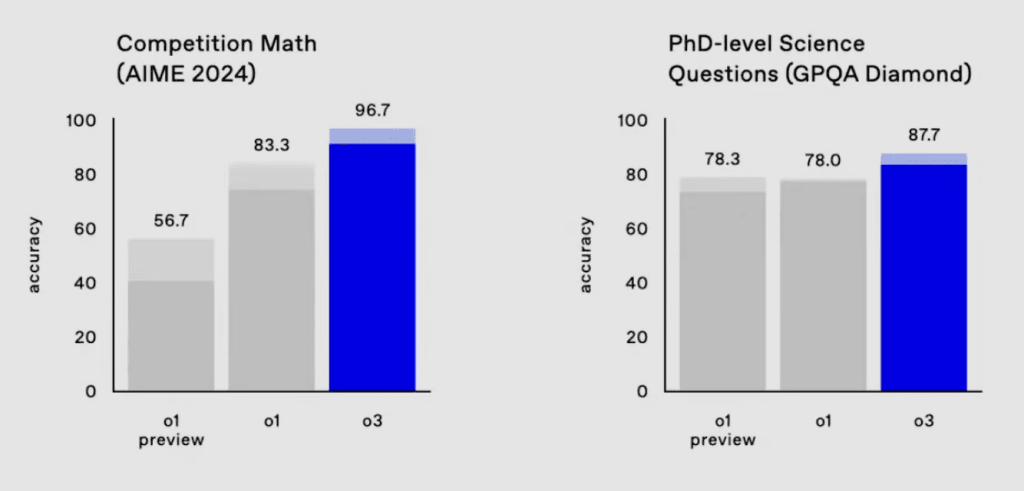

AIME : des mathématiques sous haute pression

L’American Invitational Mathematics Examination (AIME) est une référence mondiale pour évaluer les compétences mathématiques avancées. Organisé par la Mathematical Association of America (MAA), cet examen repose sur des problèmes exigeant un raisonnement déductif de haut niveau. Le modèle o3 atteint un score remarquable de 96,7 %, surpassant o1, qui avait obtenu 83,3 %. Ces résultats montrent clairement une amélioration dans la capacité à traiter des problèmes mathématiques complexes.

GPQA Diamond : une maîtrise du raisonnement contextuel

Pour tester la capacité à répondre à des questions complexes impliquant plusieurs étapes de raisonnement, GPQA Diamond offre un cadre rigoureux. Ce benchmark, fruit d’une collaboration entre OpenAI et des laboratoires académiques, a permis à o3 de briller avec un score de 87,7 %, contre 78 % pour o1. Cela illustre son aptitude à contextualiser et traiter des problèmes variés avec précision.

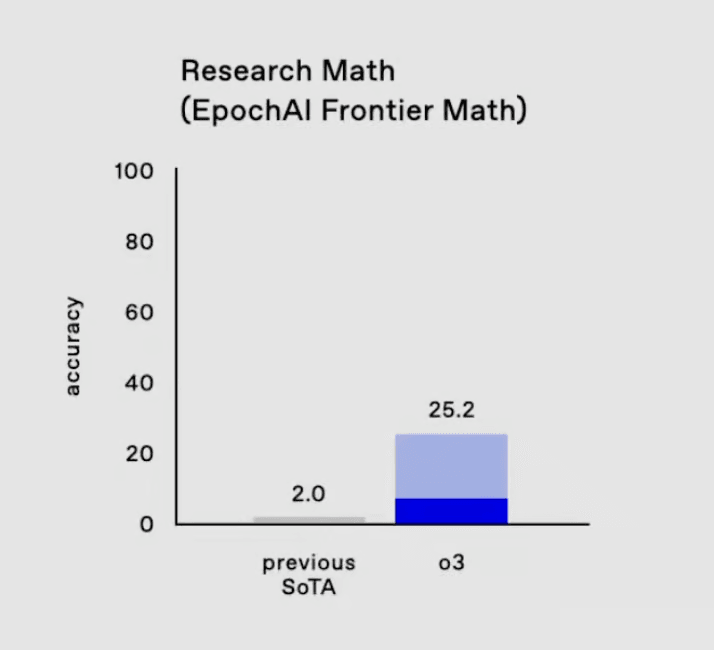

Frontier Math d’EpochAI : créativité et réflexion abstraite

Dans des scénarios mathématiques ouverts et inédits, o3 réalise un exploit en résolvant 25,2 % des problèmes. Ce test, piloté par EpochAI, met à l’épreuve la capacité des modèles à sortir des schémas pré-établis. o1, pour comparaison, obtient un score inférieur à 2 %, reflétant l’écart énorme entre les deux générations de modèles.

ARC-AGI : l’avenir de l’intelligence artificielle générale

François Chollet, créateur de Keras, dirige le test ARC (Abstraction and Reasoning Corpus). Ce test est conçu pour évaluer la créativité des IA face à des problèmes conceptuels non prévus. Avec un score impressionnant de 88 % en configuration à haute puissance, o3 surpasse même la performance humaine estimée à 85 %. Ce résultat marque une étape importante dans la capacité des IA à généraliser et à s’adapter à des tâches inconnues.

Qu’est-ce qu’OpenAI O3 mini ?

En parallèle d’o3, OpenAI a introduit o3 mini, un modèle plus économique, conçu pour répondre à des besoins variés avec une gestion adaptative des ressources. Ce modèle est idéal pour les utilisateurs qui doivent équilibrer coûts et performances. L’une des fonctionnalités remarquables de o3 mini est son temps de réflexion adaptatif, permettant d’ajuster l’effort de raisonnement selon la complexité de la tâche. Ainsi, il peut offrir des résultats proches de ceux d’o3, mais à une fraction du coût.

La sécurité au cœur de la stratégie : l’alignement délibératif

Au-delà des performances, OpenAI met un point d’honneur à la sécurité. La méthode d’alignement délibératif permet à o3 de raisonner sur les politiques de sécurité avant de produire des réponses. Contrairement aux approches statiques comme le RLHF (Reinforcement Learning with Human Feedback), cette méthode utilise un modèle de raisonnement pour générer des explications à chaque étape, améliorant ainsi la précision et la fiabilité.

OpenAI a récemment instauré un Comité de sûreté et de sécurité, dirigé par des membres de son conseil d’administration, dont le PDG Sam Altman. Ce comité est chargé de formuler des recommandations sur les décisions critiques en matière de sûreté pour tous les projets de l’entreprise. En outre, OpenAI a introduit une méthode innovante d’alignement qui va au-delà des approches classiques. Cette méthode améliore la capacité des modèles à généraliser les politiques de sécurité dans divers contextes, réduisant à la fois les refus excessifs et les réponses risquées. Ces efforts renforcent la collaboration avec des organismes externes pour garantir un développement responsable de l’intelligence artificielle.

Dates de sortie et stratégie de déploiement

Pour l’instant, o3 et o3 mini sont accessibles uniquement dans le cadre de tests publics de sécurité. OpenAI prévoit un lancement officiel de o3 mini d’ici la fin janvier 2025, suivi peu après par le modèle complet o3. Cette approche prudente vise à garantir la fiabilité et la sécurité des modèles avant leur mise à disposition générale.

Une place de choix face à la concurrence

Face à Google Gemini 2, o3 se distingue par ses capacités de raisonnement complexe, de mathématiques avancées et de programmation, tandis que Gemini 2 offre une intégration multimodale (images, texte, vidéo). En comparaison avec Claude d’Anthropic, o3 présente de meilleures capacités pour les problèmes à étapes multiples, alors que Claude est optimisé pour des interactions humaines prolongées. Par rapport aux modèles open source, o3 offre des performances supérieures sur des tests complexes, alliées à une sécurité renforcée.

Les dernières avancées vers l’AGI

Les récents progrès dans le domaine de l’intelligence artificielle montrent une tendance marquée vers le développement de l’intelligence artificielle générale (AGI). Les modèles comme o3 et Google Gemini 2 repoussent les limites de ce qui est réalisable en matière de raisonnement, de généralisation et d’adaptation. Par exemple, les performances exceptionnelles d’o3 sur le test ARC AGI démontrent une capacité à dépasser les niveaux humains dans des tâches de réflexion conceptuelle. Cette évolution est également renforcée par des innovations en sécurité, comme l’alignement délibératif d’OpenAI, qui garantissent une utilisation responsable.

D’autres acteurs, tels qu’Anthropic avec Claude 3.5 et les initiatives open source comme LLaMA de Meta, progressent également, bien que leur orientation diffère. Claude 3.5 met l’accent sur l’interaction prolongée et le langage naturel, tandis que LLaMA explore des modèles accessibles et polyvalents. Cependant, aucun ne rivalise actuellement avec la capacité d’o3 à généraliser des concepts complexes, un jalon essentiel vers l’AGI.

Ces avancées suscitent une réflexion sur les implications sociétales et éthiques de l’AGI, notamment dans la façon dont ces technologies transformeront les interactions humaines et les processus industriels.

Conclusion

Les modèles o3 et o3-mini incarnent une révolution dans l’intelligence artificielle. Avec des performances époustouflantes et une sécurité renforcée, ils redéfinissent les possibilités de l’IA moderne. Que ce soit dans les domaines du raisonnement, des mathématiques ou de la programmation, ces modèles se positionnent comme des outils incontournables pour les professionnels et chercheurs. Leur lancement, prévu pour début 2025, est attendu avec impatience.

Les modèles o3 et o3-mini incarnent une révolution dans l’intelligence artificielle. Avec des performances époustouflantes et une sécurité renforcée, ils redéfinissent les possibilités de l’IA moderne. Que ce soit dans les domaines du raisonnement, des mathématiques ou de la programmation, ces modèles se positionnent comme des outils incontournables pour les professionnels et chercheurs. Leur lancement, prévu pour début 2025, est attendu avec impatience.

FAQ

Q : Pourquoi OpenAI a-t-il sauté le modèle o2 ?

R : OpenAI a choisi de passer directement à o3 pour signaler un bond technologique majeur et éviter toute confusion avec la marque O2 de Telefonica. Cette décision reflète leur ambition de redéfinir les standards de l’IA.

Q : Qu’est-ce qui distingue o3 de Google Gemini 2 ?

R : Alors que Google Gemini 2 se concentre sur l’intégration multimodale (texte, images, vidéos), o3 excelle dans les domaines du raisonnement complexe et des mathématiques avancées, se rapprochant davantage des capacités humaines dans ces domaines spécifiques.

Q : En quoi o3 mini est-il différent d’o3 ?

R : o3 mini est une version économique d’o3, offrant des performances adaptatives pour des coûts réduits. Il est idéal pour des tâches nécessitant un raisonnement ajusté à la complexité des problèmes.

Q : Quand o3 sera-t-il disponible ?

R : o3 mini est prévu pour une sortie fin janvier 2025, tandis que le modèle complet o3 suivra peu après, après une phase approfondie de tests de sécurité.

Q : Les modèles o3 représentent-ils une véritable avancée vers l’AGI ?

R : Oui, notamment grâce à leurs performances exceptionnelles sur des tests comme ARC AGI et leur capacité à généraliser des concepts complexes. Cependant, l’AGI reste un objectif à long terme qui nécessitera encore des recherches et des avancées significatives.